El Data Warehouse es un marco para gestionar mejor, entender y sacar provecho de los datos generados por el negocio. El almacén de datos tradicional tiraba de los datos en un "depósito de la verdad", esquema impulsado para el análisis y la presentación de informes, y funcionó muy bien durante muchos años. Sin embargo, el mundo de los datos está evolucionando rápidamente en formas que están transformando la industria y las empresas están considerando nuevos enfoques de inteligencia empresarial (BI).

El data Warehouse tradicional está siendo presionado por el creciente peso del volumen explosivo de datos, la variedad de tipos de datos y la velocidad de procesamiento en tiempo real así también de cómo estos los datos se están utilizando para crecer y operar el negocio.

El almacenamiento de datos ha alcanzado el punto de inflexión más importante desde su creación. La empresa moderna necesita una arquitectura lógica que pueda escalar sin problemas para satisfacer estas demandas de volumen con una potencia de procesamiento en tiempo real y capacidad de manejar cualquier tipo de datos para conectar rápidamente el negocio con información valiosa. Esto significa que el data warehouse tradicional tiene que evolucionar hacia un data warehouse moderno.

El data warehouse tradicional fue diseñado para ser un repositorio central de todos los datos de una empresa. Los datos dispares de sistemas transaccionales como ERP, CRM y aplicaciones de línea de negocio debían ser adaptadas para extraer los datos (ETL) e introducirlo en el almacén dentro de un esquema relacional global. La estructura de datos era predecible y el procesamiento y presentación de informes de calidad optimizada. Sin embargo para la preparación de consultas se necesitaba gran medida el apoyo de tecnologías de la información TI basadas en el procesamiento por lotes programados.

La llegada de la Web 2.0 aumentó significativamente los datos relacionados con la empresa generados a través de comercio electrónico, registros web, marketing en buscadores, y otras fuentes. Las Empresas ampliaron las operaciones de ETL para compensar las nuevas fuentes de datos, en última instancia, también expandieron el modelo.

Sin embargo, incluso con estas complejidades crecientes, el valor de negocio principal del almacén de datos tradicional era la capacidad de realizar un análisis histórico y la presentación de informes procedentes de una fuente confiable y completa de datos.

Cuatro tendencias clave juntas en el entorno de negocios están poniendo el data warehouse tradicional bajo presión. En gran parte debido a estas tendencias, los profesionales de TI están evaluando formas para evolucionar sus almacenes de datos tradicionales para satisfacer las necesidades cambiantes del negocio. Las tendencias crecientes van hacia volúmenes de datos mucho más grandes, datos en tiempo real, y nuevas fuentes y tipos de datos.

El almacén de datos tradicional se basaba en tecnologías multiproceso simétrico (SMP). SMP requería más capacidad y la necesidad de adquirir hardware más grande y más potente. Esto era necesario porque a medida que el almacén de datos se acercaba a la capacidad máxima, su arquitectura experimentaba problemas de rendimiento en una escala donde no había manera de añadir la potencia del procesador incrementando o habilitando la sincronización de la caché entre procesadores.

Sin embargo, el volumen de datos se está expandiendo diez veces cada cinco años. Gran parte de estos nuevos datos son impulsados por los dispositivos de más de 1200 millones de personas que están conectadas a Internet en todo el mundo, con un promedio de 4,3 dispositivos conectados por persona. Incluyendo teléfonos inteligentes que también proporcionan soporte para sensores de monitoreo remoto, RFID, datos basados en la localización, transacciones y más.

La empresa moderna se enfrenta a la perspectiva de un hardware más grande y más potente con migraciones de datos a bases de datos cada vez más grandes no es una alternativa aceptable para el retorno de la inversión. Las empresas están buscando una alternativa al crecimiento del volumen sin que se dispare su presupuesto.

El almacén de datos tradicional (data warehouse), fue diseñado para almacenar y analizar información histórica sobre el supuesto de que los datos serían capturados ahora y analizados después. Arquitecturas de sistemas centradas en ampliación de datos relacionales con mayor hardware y procesamiento de operaciones a través de programación basada en los datos libres de errores.

Sin embargo, la velocidad de captura de datos, proceso y utilización va en aumento. Las empresas están utilizando datos en tiempo real para cambiar u optimizar sus negocios, así como para vender, realizar transacciones, y participar en los procesos dinámicos, basados en eventos como la bolsa de comercio. El almacén de datos tradicionales simplemente no fue diseñado para poder operar casi en tiempo real.

Aumento de los volúmenes de datos en tiempo real

Las transacciones o procesamiento de eventos, acaban resultando en una disminución del rendimiento y el tiempo de obteniendo siempre la velocidad de la operación más lenta.

Entre las bolsas de valores, la latencia y la velocidad a la que una venta de acciones puede ser procesada son primordiales. Una vez una empresa quería reducir la ya baja latencia de su sistema, al mismo tiempo que operaba grandes volúmenes de operaciones mucho más grandes. Con un almacén de 40 terabytes y creciendo a 2 terabytes por mes con los datos de cientos de terabytes generados a partir de más de 100 millones operaciones por día, la empresa ofreció a sus clientes un servicio más rápido, el servicio más fiable que pudo encontrar.

El almacén de datos tradicional fue construido en una estrategia de repositorio bien estructurado, con datos limpios y de confianza. Sin embargo, en la actualidad más del 85 por ciento del volumen de datos proviene de una variedad de nuevos tipos de datos y proliferación de canales móviles y sociales, escáneres, sensores, etiquetas RFID, dispositivos, y otras fuentes fuera de la empresa. Estos tipos de datos no encajan fácilmente el modelo de esquema de negocios y no puede ser rentable para ETL el almacén de datos relacional.

Sin embargo, estos nuevos tipos de datos tienen el potencial de mejorar las operaciones de negocio. Por ejemplo, una compañía de transporte podría utilizar sensores de combustible, de peso, de tráfico con GPS, el clima, etc. para optimizar las rutas de navegación o el uso de la flota.

Las empresas están respondiendo a la creciente disponibilidad de datos no relacionales mediante la implementación de entornos de datos Apache Hadoop, lo que obliga a las empresas a adoptar un nuevo paradigma con nuevos lenguajes, curvas de aprendizaje y una infraestructura separada.

Una parte creciente de los nuevos datos son tales como el rastreo de clics, vídeos, feeds sociales, GPS, datos de los mercados de valores, información meteorológica y de tráfico. Además, la tendencia prominente del movimiento aplicaciones empresariales básicas como la mensajería, CRM y ERP para las plataformas basadas en la nube también está aumentando la cantidad de datos relacionales de negocios nacidos en la nube. Los datos nacidos en la nube están cambiando las estrategias de negocio y de TI acerca de dónde se debería.

Empresas líderes de TI están buscando un nuevo enfoque de sus estrategias de inteligencia de negocio y almacenamiento de datos que se centran en la lógica de la información. Este enfoque se basa en las mejores prácticas existentes para añadir la abstracción de datos semánticos basados en procesamiento distribuido y abordar las áreas de almacenamiento de datos, virtuales (datos) de gestión, procesos distribuidos, sistema de auto-monitoreo activo, el seguimiento de nivel de servicio, y la gestión basada en los metadatos. Esta es la próxima evolución en el enfoque del almacén de datos lógicos o data warehouse.

Acceder a los datos, analizarlos, utilizarlos y almacenarlos

Una empresa que esté experimentando cualquiera de los siguientes escenarios, puede estar lista para evolucionar a un almacén de datos moderno:

-El almacén de datos es incapaz de seguir el ritmo de los volúmenes de datos de crecimiento explosivo.

-El almacén de datos se está quedando atrás en velocidad de respuesta de los requisitos de rendimiento en tiempo real.

-El almacén de datos es menos flexible de lo deseado en la adopción de una variedad de nuevas fuentes de datos.

- La plataforma es cara y el rendimiento disminuye.

Un almacén de datos moderno a la altura del BI (inteligencia de negocio) crece de forma explosiva, cambiando los tipos de datos y con procesamiento en tiempo real, con una más robusta capacidad de entregar los datos correctos en el momento adecuado.

Un almacén de datos moderno debe ofrecer una plataforma de datos lógicos y analítica completa con un conjunto completo de soporte, soluciones y tecnologías que puedan satisfacer las necesidades más sofisticadas y exigentes, en la nube, o dentro de cualquier escenario hibrido.

Gestión y procesamiento de datos

El almacén de datos moderno debe tener capacidad para manejar tanto las fuentes de datos relacionales y no relacionales como Hadoop como base para tomar decisiones de negocio. Podrá manejar datos en tiempo real, utilizando las tecnologías de procesamiento de eventos complejos. Permitirá aumentar fácilmente los datos internos con datos externos a la organización. Por último, debe ofrecer un motor analítico para análisis predictivo y exploración interactiva de los datos agregados desde diferentes perspectivas.

Enriquecimiento de datos y consulta federada

El almacén de datos moderno tendrá también la capacidad de enriquecer sus datos con extracción, transformación y capacidades de carga (ETL), así como el apoyo en datos fiables y consistentes a través de servicios de calidad de datos y gestión de datos maestros. También proporcionará un único mecanismo de consulta a través de estos diferentes tipos de datos a través de un servicio de consulta federada.

Inteligencia de negocios y análisis

Debe ser compatible con la amplitud de herramientas que las organizaciones pueden utilizar para obtener resultados procesables de los datos. Incluyendo herramientas de autoservicio que hacen que sea fácil para los usuarios de negocios analizar los datos con herramientas con las que ya están familiarizados. Los usuarios del negocio podrán crear y compartir los análisis en un entorno de equipo a través de una variedad de dispositivos. Por último, la plataforma debe ser compatible con los modelos de análisis predictivo para ayudar en tiempo real, a la toma de decisiones.

El almacén de datos moderno debe satisfacer las necesidades de la empresa actual para conectar inteligencia de negocio con los tomadores de decisiones del negocio. Cabe destacar la capacidad de manejar:

Todos los volúmenes

Rendimiento en tiempo real

Cualquier dato

Sobre la base de las tecnologías de SMP, los almacenes de datos tradicionales procesaban consultas de forma secuencial. Cuando se necesitaban más datos, se instalaba una máquina más potente y más grande, se aumentaba el hardware, lo que representaba un nuevo límite en el tamaño de los datos a almacenar hasta la siguiente nueva inversión en hardware. Además, SMP podía ser problemático en grandes bases de datos, con temas relacionados con la escalabilidad de los procesadores, memoria caché de sincronización entre procesadores, y el rendimiento del sistema al ejecutar cargas simultáneas. En total, esto significaba plataformas muy caras, con límites de tamaño de los datos que ralentizaban el rendimiento e impedían el crecimiento desmesurado de información almacenada.

Caso de estudio: Supermercados

Usando el sistema antiguo, los analistas trabajaban con datos que tenían dos semanas, así que era difícil para reaccionar a las tendencias. Ahora, se pueden ver los datos de ventas del día anterior todas las mañanas. Así que en medio de una promoción para un producto determinado, los analistas pueden ver por la mañana el comportamiento de los clientes del día anterior y tomar decisiones rápidamente.

Escalar datos relacionales

Se ha rediseñado SQL Server en una arquitectura de procesamiento paralelo múltiple (MPP) paralela al almacenamiento de datos (PDW) Tecnología de procesamiento distribuido para manejar las modernas realidades de datos. La arquitectura MPP permite una poderosa computación distribuida y escalable. Este tipo de tecnología similar a los superordenadores logra una gran potencia de computación. Si se necesitan más recursos, estos se pueden agregar de forma casi lineal.

La arquitectura de datos MPP utiliza una arquitectura "shared-nothing", donde hay múltiples nodos físicos, cada uno ejecutando su propia instancia de SQL Server con una CPU, memoria y almacenamiento dedicadas. Con esto el rendimiento es mucho más rápido que las arquitecturas tradicionales. Es posible escalar fácilmente el almacén de datos de SQL Server desde 11 terabytes a varias veces ese tamaño sin necesidad de añadir nuevo hardware.

Un motor MPP permite soportar grandes bases de datos complementarias de varios petabytes de capacidad. Se añade calidad a los datos, que crecen de forma incremental y sobre una base continua, simplemente añadiendo incrementales de hardware.

MPP se ocupa de las cuestiones relacionadas con la escalabilidad de los procesadores SMP y la sincronización de la caché entre procesadores. Las consultas Transact-SQL que pasan por el sistema, se dividen para ejecutarse de forma simultánea a través de múltiples nodos físicos, que ofrecen alto rendimiento a escala a través de la ejecución en paralelo. También permite una alta concurrencia en consultas complejas a escala, que pueden ser optimizadas para cargas de trabajo mixtas y para análisis de datos en tiempo real. La arquitectura se integra dentro de SQL Server 2012 Parallel Data Warehouse.

Escalar los datos no relacionales

El almacén de datos tradicional se actualiza para añadir datos no relacionales mediante la instalación y el mantenimiento del sistema Hadoop. Hadoop es un marco de software de código abierto que permite el procesamiento distribuido de grandes conjuntos de datos a través de clusters de computadores. Hadoop ha impulsado la conversión de grandes volúmenes de datos gracias a su capacidad para manejar grandes cantidades de datos no relacionales a través de clusters de hardware. Hadoop utiliza el sistema de archivos de datos Hadoop (HDFS), que puede soportar datos no relacionales utilizando el lenguaje de programación MapReduce. El incremento de escala en clúster Hadoop existente es una cuestión de añadir más clusters de Hadoop de forma incremental.

Hortonworks es una plataforma de datos para Windows disponible como software independiente que ofrece un entorno Hadoop. HDInsight integra Hadoop dentro de un procesamiento de almacenamiento de datos en paralelo (PDW) para sacar ventaja del procesamiento distribuido de MPP. La ampliación de la nube también está habilitada fácilmente con el servicio de HDInsight Hadoop en Windows Azure. El Moderno almacén de datos permite escalar los datos no relacionales con la agilidad de despliegue.

El almacén de datos tradicional estaba menos preocupado con el rendimiento de la consulta y más con la integridad de los datos, porque la mayoría de los análisis se realizaban sobre datos históricos. Sin embargo, la empresa moderna funciona en tiempo real y necesita una plataforma de datos que pueda seguir el ritmo de la demanda, sin perder rendimiento y ofrecer conocimientos oportunos, y flujo de datos para aplicaciones cerca de procesamiento en tiempo real.

Rendimiento del almacén de columnas en la memoria

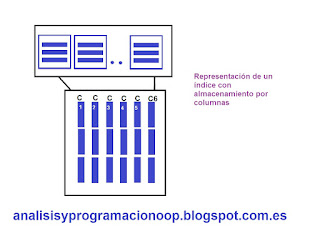

El almacén de datos tradicional, surgió a partir del concepto de registros de datos o filas, se utilizó un diseño de almacenamiento de datos en filas. Sin embargo, el almacenamiento por filas no es óptimo para muchas consultas basadas en esquemas en estrella. La tecnología de almacenamiento por columnas en las tablas de hecho dentro de un esquema en estrella mejora el rendimiento de las consultas para tablas grandes, reduciendo la cantidad de datos que necesitan ser procesadas a través de E / S.

El almacenamiento en memoria por columnas cambia el motor de almacenamiento primario a un formato de columnas actualizables e indexado en memoria, que agrupa, almacena e indexa los datos en segmentos de columna comprimidos.

El almacenamiento en memoria por columnas mejora el rendimiento de consultas sobre los almacenes de datos tradicionales, ya que sólo lee las columnas necesarias para cada consulta. Por lo tanto, lee menos datos desde el disco a la memoria y también minimiza la cantidad de información trasladada desde la memoria a la memoria caché del procesador. Las columnas se comprimen mucho, lo que reduce el número de bytes a leer o mover.

Además el almacenamiento en memoria por columnas maximiza el uso de la CPU mediante el aprovechamiento de la memoria en el proceso de la consulta, el acceso a los datos almacenados en memoria. Dentro de la memoria de columnas también acelera la velocidad de procesamiento utilizando el índice de columna secundaria para consultar de forma selectiva y mejorar el rendimiento en tiempo real el acceso por columnas comprime los datos, lo que reduce aún más la necesidad de acceso de E / S a los medios físicos por nodo.

En combinación, estas técnicas resulta en compresión masiva (hasta 10 veces), y en grandes ganancias en rendimiento (hasta 100 veces). El almacenamiento en memoria por columnas puede mejorar el rendimiento de las consultas, incluso sobre la base de las inversiones en hardware existentes.

El almacenamiento en memoria por columnas, es capaz de extraer 100 millones de registros en 2 o 3 segundos, frente a los 30 minutos requeridos con anterioridad.

El almacén de datos tradicional proporciona una estrategia para el almacenamiento y análisis de datos históricos de tendencias y presentación de informes. Sin embargo, la empresa moderna necesita datos en tiempo real ya que los datos no simplemente proporcionan perspectivas históricas, sino que desempeñan un papel activo en la optimización de las operaciones.

Las aplicaciones de procesamiento de eventos complejos CEP permiten el uso de flujo de datos en tiempo real creados por tecnologías como RFID, sensores y otras tecnologías que apoyen las operaciones controladas por eventos. Ejemplos de las aplicaciones de CEP se incluyen por ejemplo en optimización de procesos de fabricación, aplicaciones de comercio financiero, análisis web y análisis de operaciones.

Una aplicación de este tipo es StreamInsight, que utiliza una arquitectura de procesamiento de flujo de alto rendimiento y una plataforma de desarrollo basada en Microsoft .NET Framework.

El data warehouse moderno, aprovecha las ventajas de un rendimiento 100 veces más rápido que el almacén de datos tradicional y capacidad de soportar el procesamiento en tiempo real.

Los almacenes de datos relacionales tradicionales que gestionan datos históricos, tales como ERP, CRM y salidas de línea de negocio, se siguen utilizando con el objetivo fundamental de establecer un repositorio central como fuente de datos reales para el negocio. Con la Web 2.0 llegó una avalancha de nuevos datos, incluyendo los negocios de comercio electrónico, marketing en buscadores, etc. y estableció operaciones de ETL y de enriquecimiento de datos costosos de llevar almacén de datos tradicional. Estos nuevos datos ampliaron el modelo de esquema relacional, lo que dio lugar a una complejidad adicional.

No hay comentarios:

Publicar un comentario